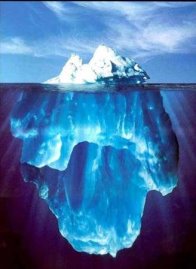

| Les moteurs de recherches bien que de plus en plus perfectionnées n’indexent pas l’intégralité du Web. Aussi, en opposition au Web Surfacique, le web profond ou web invisible (deep web en anglais) est la partie du web accessible en ligne, mais non indexée par des moteurs de recherche classiques généralistes. Il existe néanmoins des moteurs spécialisés dans la recherche de données de ce type tels que BASE. Le web sombre désigne les parties du web non accessibles en ligne. Le web invisible est la partie du web sombre indexable, mais non indexée. Le web invisible et le web sombre sont néanmoins accessibles en ligne aux internautes. |  |

Pourquoi le web invisible n’est-il pas indexé ?

Pour des raisons essentiellement techniques : Les robots d’indexation sont des programmes utilisés par les moteurs de recherche pour parcourir le web. Afin de découvrir de nouvelles pages, ces robots suivent les hyperliens. Les ressources profondes sont celles qui ne peuvent pas être atteintes facilement par les moteurs de recherche.

On peut classifier en plusieurs catégories les ressources du web invisible :

- Les données de pages non liées, autrement ne disposant par d’hyperlien permettant aux robots de les trouver, se sont des pages sans backlinks (ou inlinks).

- Les données dont le format n’est pas contenu des robots d’exploration.

- Les données produites par certains scripts (JavaScript, Ajax ou en Flash) sont difficilement visibles par les robots, donc non indexables.

- Les données dont l’accès est limité par un fichier qui empêche les moteurs de recherche de les explorer et de créer des copies en cache (robot.txt).

- Les données ne sont accessibles qu’après saisie d’un mot de passe (.htaccess)

- Les données dynamiques générées uniquement en réponse aux données entrées dans un formulaire. Un robot n’étant en mesure de remplir lui-même un formulaire, les données ne sont pas accessibles dans l’état.

- Les données dont le contenu ne semble pas intéressant du point de vue du moteur de recherche.

- Les données censurées

Les moteurs de recherche n’indexant pas en temps réel, certaines données pages web peuvent ne pas être visibles à un moment donné et l’être un peu plus tard. Nous ne sommes donc pas ici dans le domaine du web invisible.

Quel est le volume de données du Web profond ?

En 2001, l’entreprise BrightPlanet estime que le web profond pouvait contenir 500 fois plus de ressources que le web surfacique qui représentait à lui seul 167 téraoctets. D’après des études faites à l’Université de Berkeley, la taille du web profond est estimée à environ 91 000 téraoctets.

| En 2008, le web invisible représente 70 à 75% de l’ensemble, soit environ un trilliard de pages non indexées.Les proportions de pages indexées d’un moteur à l’autre sont variables, car les al Il est fort probable que les proportions entre Web indexé et web non indexé évolue au file du temps, car les moteurs de recherche sont de plus en plus en mesure d’indexer certaines catégorie du web profond, notamment celles accessibles via des langages de programmation comme flash, que certains moteurs comme Google, sont désormais en mesure d’interpréter. Pour palier les difficultés des moteurs à pouvoir indexer des sites comportant de nombreuses pages dynamiques, Google à proposé le protocole sitemap qui recense les pages d’un site web. Ce sitemap est un fichier xml déposé à la racine du site et généré par l’administrateur. |  |

Moteurs d’accès au web invisible :

BASE

Deeppeep est un moteur de recherche qui permet de trouver des bases de données en ligne thématiques. Plus spécifiquement, il trouve des pages disposant de formulaires de recherche et vous permet de les interroger. En cela il peut être considéré comme un outil au service de l’exploration du web invisible.

Pipl http://pipl.com/